Bisakah AI generatif yang dirancang untuk perusahaan (misalnya AI yang melengkapi laporan secara otomatis, rumus spreadsheet, dan sebagainya) dapat dioperasikan? Bersama dengan sejumlah organisasi termasuk Cloudera dan Intel, Linux Foundation – organisasi nirlaba yang mendukung dan memelihara sejumlah upaya open source – bertujuan untuk mencari tahu.

Linux Foundation hari ini diumumkan peluncuran Open Platform for Enterprise AI (OPEA), sebuah proyek untuk mendorong pengembangan sistem AI generatif yang terbuka, multi-penyedia, dan dapat disusun (yaitu modular). Di bawah lingkup LFAI dan organisasi Data Linux Foundation, yang berfokus pada inisiatif platform terkait AI dan data, tujuan OPEA adalah membuka jalan bagi peluncuran sistem AI generatif yang “lebih kuat”, “dapat diskalakan”, dan “memanfaatkan” inovasi open source terbaik dari seluruh ekosistem,” direktur eksekutif LFAI dan Data Ibrahim Haddad mengatakan dalam siaran pers.

“OPEA akan membuka kemungkinan-kemungkinan baru dalam AI dengan menciptakan kerangka kerja yang terperinci dan dapat disusun yang berada di garis depan teknologi,” kata Haddad. “Inisiatif ini merupakan bukti misi kami untuk mendorong inovasi dan kolaborasi sumber terbuka dalam AI dan komunitas data di bawah model tata kelola yang netral dan terbuka.”

Selain Cloudera dan Intel, OPEA — salah satu Proyek Sandbox milik Linux Foundation, yang merupakan semacam program inkubator — juga termasuk di antara anggotanya adalah perusahaan-perusahaan kelas berat seperti Intel, Red Hat milik IBM, Hugging Face, Domino Data Lab, MariaDB, dan VMWare.

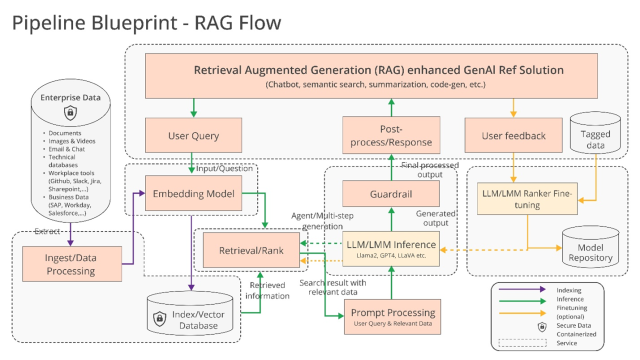

Jadi, apa sebenarnya yang bisa mereka bangun bersama? Haddad mengisyaratkan beberapa kemungkinan, seperti dukungan yang “dioptimalkan” untuk toolchain dan compiler AI, yang memungkinkan beban kerja AI dijalankan di berbagai komponen perangkat keras, serta pipeline “heterogen” untuk retrieval-augmented generation (RAG).

RAG menjadi semakin populer dalam aplikasi AI generatif di perusahaan, dan tidak sulit untuk mengetahui alasannya. Jawaban dan tindakan sebagian besar model AI generatif terbatas pada data yang dilatih. Namun dengan RAG, basis pengetahuan model dapat diperluas ke informasi di luar data pelatihan asli. Model RAG mereferensikan informasi luar ini — yang dapat berupa data milik perusahaan, database publik, atau kombinasi keduanya — sebelum menghasilkan respons atau melakukan tugas.

Diagram yang menjelaskan model RAG.

Intel menawarkan beberapa detail lebih lanjut jumpa pers:

Perusahaan ditantang dengan pendekatan do-it-yourself [to RAG] karena tidak ada standar de facto di seluruh komponen yang memungkinkan perusahaan memilih dan menerapkan solusi RAG yang terbuka dan dapat dioperasikan serta membantu mereka memasuki pasar dengan cepat. OPEA bermaksud untuk mengatasi permasalahan ini dengan berkolaborasi dengan industri untuk melakukan standarisasi komponen, termasuk kerangka kerja, cetak biru arsitektur dan solusi referensi.

Evaluasi juga akan menjadi bagian penting dalam penanganan OPEA.

Di GitHub-nya gudangOPEA mengusulkan rubrik untuk menilai sistem AI generatif dalam empat aspek: kinerja, fitur, kepercayaan, dan kesiapan “tingkat perusahaan”. Pertunjukan sebagaimana didefinisikan OPEA, hal ini berkaitan dengan tolok ukur “kotak hitam” dari kasus penggunaan di dunia nyata. Fitur adalah penilaian interoperabilitas sistem, pilihan penerapan, dan kemudahan penggunaan. Kepercayaan melihat kemampuan model AI untuk menjamin “kekokohan” dan kualitas. Dan kesiapan perusahaan berfokus pada persyaratan untuk mengaktifkan dan menjalankan sistem tanpa masalah besar.

Rachel Roumeliotis, direktur strategi sumber terbuka di Intel, mengatakan bahwa OPEA akan bekerja sama dengan komunitas sumber terbuka untuk menawarkan pengujian berdasarkan rubrik tersebut — dan memberikan penilaian serta penilaian penerapan AI generatif berdasarkan permintaan.

Upaya-upaya OPEA lainnya masih belum jelas saat ini. Namun Haddad mengungkapkan potensi pengembangan model terbuka sejalan dengan perluasan keluarga Llama Meta dan DBRX Databricks. Untuk mencapai tujuan tersebut, dalam repo OPEA, Intel telah menyumbangkan implementasi referensi untuk chatbot bertenaga AI generatif, peringkas dokumen, dan pembuat kode yang dioptimalkan untuk perangkat keras Xeon 6 dan Gaudi 2.

Saat ini, para anggota OPEA jelas-jelas berinvestasi (dan dalam hal ini memiliki kepentingan pribadi) dalam membangun peralatan untuk AI generatif perusahaan. Cloudera baru-baru ini meluncurkan kemitraan untuk menciptakan apa yang disebut sebagai “ekosistem AI” di cloud. Domino menawarkan a rangkaian aplikasi untuk membangun dan mengaudit AI generatif yang memajukan bisnis. Dan VMWare – yang berorientasi pada sisi infrastruktur AI perusahaan – diluncurkan pada bulan Agustus lalu produk komputasi “AI pribadi” yang baru.

Pertanyaannya adalah – di bawah OPEA – apakah vendor-vendor ini akan melakukan hal tersebut Sebenarnya bekerja sama untuk membangun alat AI yang kompatibel secara lintas?

Ada manfaat nyata dari melakukan hal tersebut. Pelanggan akan dengan senang hati memanfaatkan banyak vendor tergantung pada kebutuhan, sumber daya, dan anggaran mereka. Namun sejarah telah menunjukkan bahwa sangat mudah bagi kita untuk cenderung melakukan vendor lock-in. Semoga saja itu bukan hasil akhir di sini.