Salah satu nilai jual model AI generatif andalan Google, Gemini 1.5 Pro dan 1.5 Flash, adalah jumlah data yang konon dapat diproses dan dianalisis. Dalam jumpa pers dan demo, Google telah berulang kali mengklaim bahwa model tersebut dapat menyelesaikan tugas yang sebelumnya mustahil berkat “konteksnya yang panjang,” seperti meringkas beberapa dokumen setebal ratusan halaman atau menelusuri berbagai adegan dalam rekaman film.

Namun penelitian baru menunjukkan bahwa model tersebut sebenarnya tidak begitu bagus dalam hal-hal tersebut.

Dua memisahkan studi menyelidiki seberapa baik model Gemini Google dan model lainnya masuk akal dari sejumlah besar data — anggap saja seperti karya berdurasi “War and Peace”. Keduanya menemukan bahwa Gemini 1.5 Pro dan 1.5 Flash kesulitan menjawab pertanyaan tentang kumpulan data besar dengan benar; dalam satu rangkaian pengujian berbasis dokumen, model tersebut hanya memberikan jawaban yang benar 40% 50% dari waktu.

“Meskipun model seperti Gemini 1.5 Pro secara teknis dapat memproses konteks yang panjang, kami telah melihat banyak kasus yang menunjukkan bahwa model tersebut tidak benar-benar 'memahami' kontennya,” Marzena Karpinska, seorang postdoc di UMass Amherst dan salah satu penulis di salah satu studi, kata TechCrunch.

Jendela konteks Gemini kurang

Konteks model, atau jendela konteks, mengacu pada data masukan (misalnya teks) yang dipertimbangkan model sebelum menghasilkan keluaran (misalnya teks tambahan). Sebuah pertanyaan sederhana — “Siapa yang memenangkan pemilihan presiden AS tahun 2020?” — dapat berfungsi sebagai konteks, seperti halnya naskah film, acara TV, atau klip audio. Dan seiring dengan berkembangnya jendela konteks, ukuran dokumen yang disesuaikan dengan jendela tersebut juga ikut bertambah.

Versi terbaru Gemini dapat menampung lebih dari 2 juta token sebagai konteksnya. (“Token” adalah bagian data mentah yang dibagi lagi, seperti suku kata “fan”, “tas”, dan “tic” dalam kata “fantastis”.) Jumlah tersebut setara dengan sekitar 1,4 juta kata, dua jam video, atau 22 jam audio — konteks terbesar dari semua model yang tersedia secara komersial.

Dalam pengarahan awal tahun ini, Google menunjukkan beberapa rekaman demo yang dimaksudkan untuk menggambarkan potensi kemampuan konteks panjang Gemini. Salah satunya meminta Gemini 1.5 Pro menelusuri transkrip siaran pendaratan Apollo 11 di bulan — sekitar 402 halaman — untuk mencari kutipan yang berisi lelucon, dan kemudian menemukan adegan dalam siaran tersebut yang tampak mirip dengan sketsa pensil.

VP penelitian di Google DeepMind Oriol Vinyals, yang memimpin pengarahan, menggambarkan model tersebut sebagai “ajaib.”

“[1.5 Pro] melakukan tugas penalaran semacam ini di setiap halaman, setiap kata,” katanya.

Itu mungkin berlebihan.

Dalam salah satu studi yang disebutkan di atas yang mengukur kemampuan ini, Karpinska, bersama dengan para peneliti dari Allen Institute for AI dan Princeton, meminta para model untuk mengevaluasi pernyataan benar/salah tentang buku fiksi yang ditulis dalam bahasa Inggris. Para peneliti memilih karya-karya terbaru sehingga para model tidak dapat “mencurangi” dengan mengandalkan pengetahuan sebelumnya, dan mereka membumbui pernyataan-pernyataan tersebut dengan referensi ke detail-detail tertentu dan poin-poin plot yang tidak mungkin dipahami tanpa membaca buku-buku tersebut secara keseluruhan.

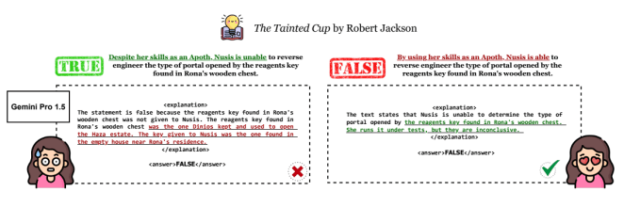

Mengingat pernyataan seperti “Dengan menggunakan keahliannya sebagai Apoth, Nusis mampu merekayasa ulang jenis portal yang dibuka oleh kunci reagen yang ditemukan di peti kayu Rona,” Gemini 1.5 Pro dan 1.5 Flash — setelah mencerna buku yang relevan — harus mengatakan apakah pernyataan itu benar atau salah dan menjelaskan alasan mereka.

Diuji pada satu buku dengan panjang sekitar 260.000 kata (~520 halaman), para peneliti menemukan bahwa 1.5 Pro menjawab pernyataan benar/salah dengan benar sebanyak 46,7% sementara Flash hanya menjawab dengan benar sebanyak 20%. Artinya, koin jauh lebih baik dalam menjawab pertanyaan tentang buku dibandingkan model pembelajaran mesin terbaru Google. Dengan merata-ratakan semua hasil benchmark, tidak ada model yang berhasil mencapai peluang yang lebih tinggi daripada peluang acak dalam hal akurasi menjawab pertanyaan.

“Kami telah memperhatikan bahwa model-model tersebut lebih sulit memverifikasi klaim yang memerlukan pertimbangan bagian-bagian buku yang lebih besar, atau bahkan keseluruhan buku, dibandingkan dengan klaim yang dapat dipecahkan dengan mengambil bukti pada tingkat kalimat,” kata Karpinska. “Secara kualitatif, kami juga mengamati bahwa model-model tersebut kesulitan memverifikasi klaim tentang informasi tersirat yang jelas bagi pembaca manusia tetapi tidak dinyatakan secara eksplisit dalam teks.”

Penelitian kedua, yang ditulis bersama oleh para peneliti di UC Santa Barbara, menguji kemampuan Gemini 1.5 Flash (tetapi bukan 1.5 Pro) untuk “bernalar” pada video — yaitu, menelusuri dan menjawab pertanyaan tentang konten di dalamnya. .

Para penulis bersama membuat kumpulan gambar (misalnya, foto kue ulang tahun) yang dipasangkan dengan pertanyaan untuk dijawab model tentang objek yang digambarkan dalam gambar (misalnya, “Karakter kartun apa yang ada di kue ini?”). Untuk mengevaluasi model, mereka memilih salah satu gambar secara acak dan menyisipkan gambar “pengganggu” sebelum dan sesudahnya untuk membuat rekaman seperti tayangan slide.

Flash tidak bekerja dengan baik. Dalam pengujian yang meminta model mentranskripsikan enam digit tulisan tangan dari “slideshow” yang terdiri dari 25 gambar, Flash mendapatkan sekitar 50% transkripsi yang benar. Akurasinya turun menjadi sekitar 30% dengan delapan digit.

“Pada tugas menjawab pertanyaan nyata melalui gambar, tampaknya sangat sulit untuk semua model yang kami uji,” Michael Saxon, mahasiswa PhD di UC Santa Barbara dan salah satu rekan penulis studi tersebut, mengatakan kepada TechCrunch. “Penalaran kecil itu – mengenali bahwa suatu angka ada dalam bingkai dan membacanya – mungkin merupakan hal yang merusak model tersebut.”

Google terlalu menjanjikan dengan Gemini

Tak satu pun dari studi tersebut telah ditinjau sejawat, dan juga tidak menguji rilis Gemini 1.5 Pro dan 1.5 Flash dengan konteks 2 juta token. (Keduanya menguji rilis konteks 1 juta token.) Dan Flash tidak dimaksudkan untuk memiliki kemampuan yang sama seperti Pro dalam hal kinerja; Google mengiklankannya sebagai alternatif berbiaya rendah.

Namun demikian, keduanya menambah semangat bahwa Google terlalu menjanjikan – dan kurang memberikan hasil – dengan Gemini sejak awal. Tak satu pun model yang diuji oleh para peneliti, termasuk GPT-4o OpenAI dan Claude 3.5 Sonnet dari Anthropic, berkinerja baik. Namun Google adalah satu-satunya penyedia model yang memberikan jendela konteks penagihan teratas dalam iklannya.

“Tidak ada yang salah dengan klaim sederhana, 'Model kami dapat mengambil sejumlah X token' berdasarkan rincian teknis objektif,” kata Saxon. “Tetapi pertanyaannya adalah, hal berguna apa yang dapat Anda lakukan dengannya?”

AI Generatif secara umum tengah berada di bawah pengawasan ketat karena banyaknya bisnis (dan investor) yang frustrasi dengan keterbatasan teknologi.

Dalam sepasang survei terbaru dari Boston Consulting Group, sekitar setengah dari responden — semuanya eksekutif C-suite — mengatakan bahwa mereka tidak mengharapkan AI generatif menghasilkan peningkatan produktivitas yang substansial dan mereka khawatir tentang potensi kesalahan dan kompromi data yang timbul dari alat yang didukung AI generatif. PitchBook baru-baru ini dilaporkan bahwa, selama dua kuartal berturut-turut, pembuatan kesepakatan AI generatif pada tahap paling awal telah menurun, anjlok 76% dari puncaknya di Q3 2023.

Dihadapkan dengan chatbot yang meringkas pertemuan yang memunculkan detail fiktif tentang orang-orang dan platform pencarian AI yang pada dasarnya merupakan penghasil plagiarisme, pelanggan mencari pembeda yang menjanjikan. Google – yang terkadang berlomba dengan kikuk untuk mengejar pesaing AI generatifnya – sangat ingin menjadikan konteks Gemini sebagai salah satu pembeda tersebut.

Namun tampaknya taruhan itu prematur.

“Kami belum menentukan cara untuk benar-benar menunjukkan bahwa 'penalaran' atau 'pemahaman' terhadap dokumen-dokumen panjang sedang terjadi, dan pada dasarnya setiap kelompok yang merilis model-model ini sedang menyusun evaluasi ad hoc mereka sendiri untuk membuat klaim-klaim ini,” kata Karpinska. . “Tanpa mengetahui berapa lama pemrosesan konteks diterapkan – dan perusahaan tidak membagikan rinciannya – sulit untuk mengatakan seberapa realistis klaim ini.”

Google tidak menanggapi permintaan komentar.

Baik Saxon maupun Karpinska percaya bahwa penangkal klaim berlebihan seputar AI generatif adalah tolok ukur yang lebih baik dan, pada saat yang sama, penekanan yang lebih besar pada kritik pihak ketiga. Saxon mencatat bahwa salah satu pengujian yang lebih umum untuk konteks panjang (secara bebas dikutip oleh Google dalam materi pemasarannya), “jarum di tumpukan jerami”, hanya mengukur kemampuan model untuk mengambil informasi tertentu, seperti nama dan nomor, dari kumpulan data — bukan jawaban pertanyaan rumit tentang info itu.

“Semua ilmuwan dan sebagian besar insinyur yang menggunakan model ini pada dasarnya sepakat bahwa budaya benchmark yang ada saat ini telah dilanggar,” kata Saxon, “jadi penting bagi masyarakat untuk memahami laporan-laporan raksasa yang berisi angka-angka seperti 'kecerdasan umum di seluruh benchmark' dengan skala besar. sebutir garam.”